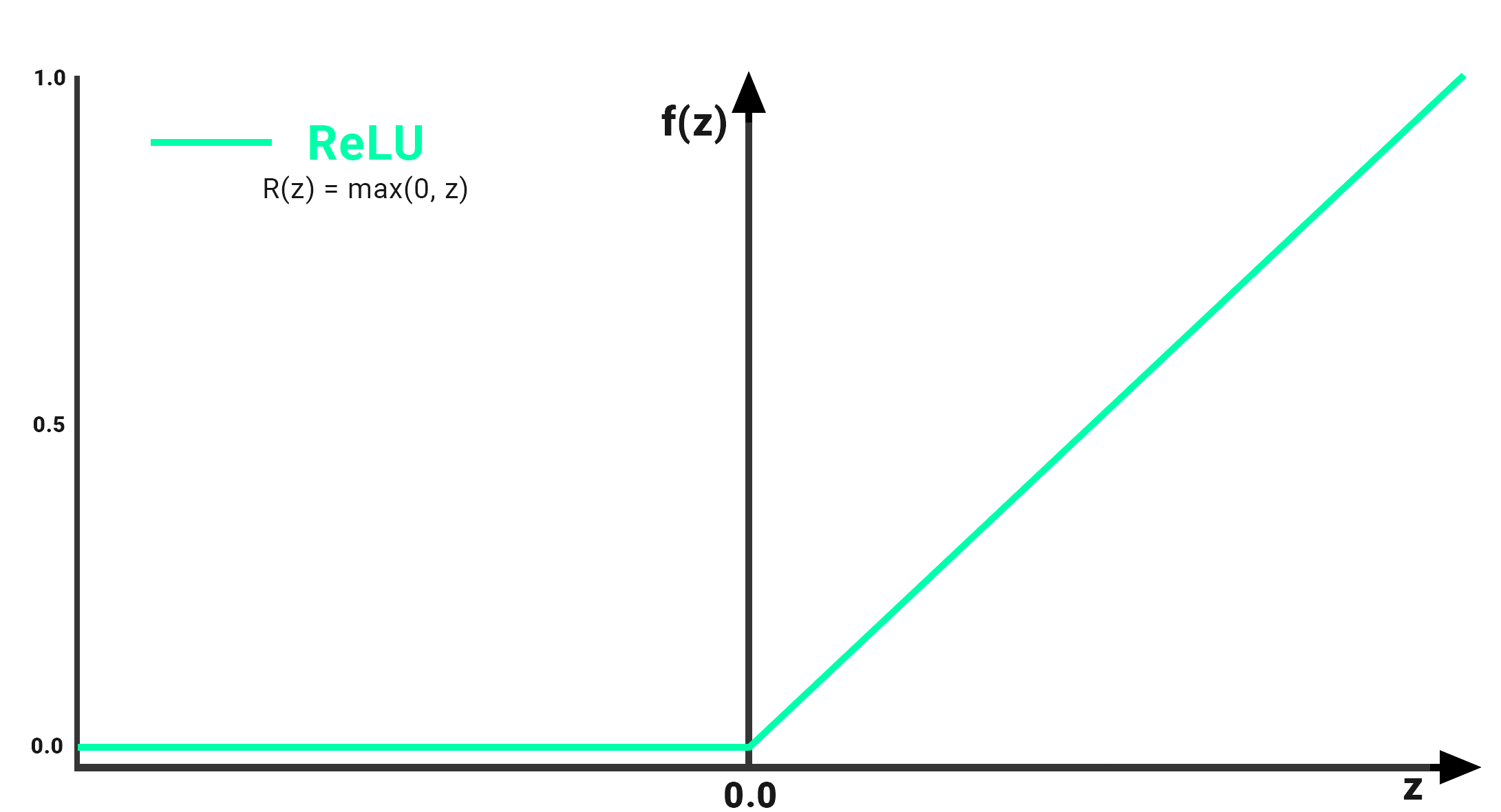

ReLU함수란 무엇인가? ReLU 활성화 함수 특징과 구현방법

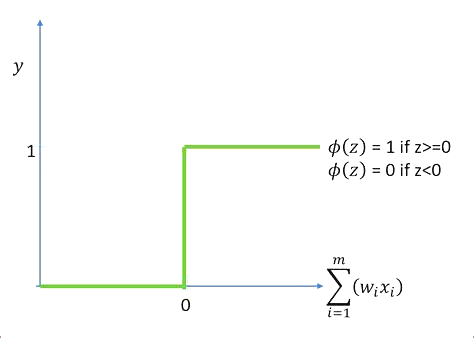

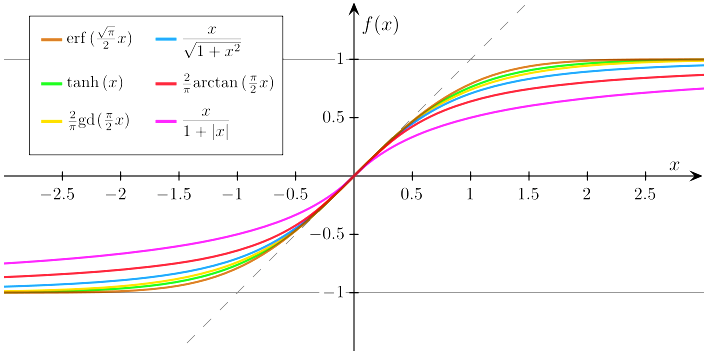

목차 개요 ReLU(Rectified Linear Unit) 함수는 신경망에서 일반적으로 사용되는 비선형 활성화 함수입니다. 다음과 같이 정의됩니다. ReLU(x) = max(0, x) 모든 음수 입력 값을 0으로 매핑하고 음수가 아닌 모든 입력 값을 그대로 유지합니다. 이 함수는 실수에 대해서만 정의되며, 양수일 때 입력과 음수일 때 0과 같은 출력을 생성합니다. 특징 ReLU 활성화 함수는 구현이 간단하고 계산적으로 효율적이며 0에서 간단한 임계값 연산으로 정의되며 지수나 로그와 같은 복잡한 수학 연산이 없습니다. ReLU는 시그모이드와 같은 다른 활성화 함수에서 흔히 발생하는 기울기 소실 문제를 방지하는 데 도움이 되기 때문에 심층 신경망에서 널리 사용됩니다. ReLU 함수의 그래디언트는 0 또는 ..